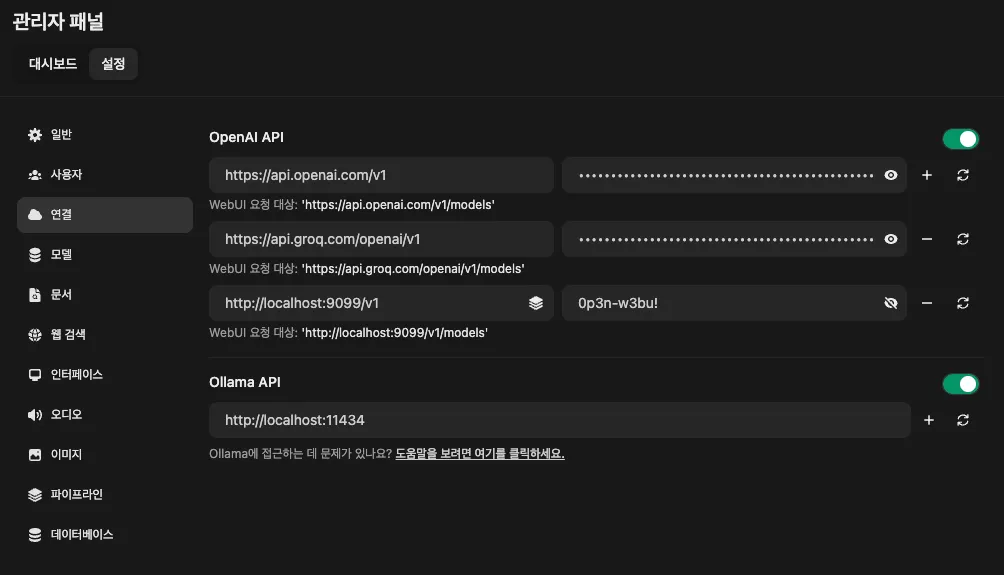

Open WebUI에서 제공하는 유용한 기능 중 하나가 바로 유튜브 요약 기능입니다.유튜브에서 흥미로운 주제의 영상을 클릭했는데, 막상 긴 서론과 비효율적인 내용으로 시간만 허비한 경험, 한 번쯤 있으셨을 겁니다. 특히 강의나 인터뷰 같은 영상 콘텐츠에서 도입부에 큰 기대를 갖게 만들고 정작 핵심 내용 없이 긴 시간 동안 주변 이야기만 이어가는 경우는 흔히 발생합니다.유튜브 요약 기능은 사용자가 유튜브 동영상의 내용을 빠르게 파악할 수 있도록 동영상의 주요 내용을 텍스트로 요약해주는 도구입니다. 특히 긴 동영상이나 특정 정보를 찾고 싶은 경우 매우 유용합니다. 기능 사용 방법1. 설정관리자 페이지 웹 검색에서 유튜브 로더 설정의 언어를 ko로 변경해줍니다. 2. 사용법Open WebUI의 유튜브 요약 기..